1 概述

1.1 版本

| 服务器版本 | 功能变更 |

|---|---|

| v7.2.0 | |

| v7.3.0 | 1、扩充组件:文件输入、字段配置、新增字段、数据去重、数据过滤、JSON解析、列转行、行转列; 2、更改组件分类 |

1.2 应用场景

若实际业务场景中需要对抽取的数据进行复杂的数据处理(比如:行列转换、数据关联、数据比对等),则需要使用【数据转换】功能。

注:若只是将数据抽取同步到数据库中,而且同步的数据不需要非常复杂的数据处理,则可以使用“数据同步”节点。

1.3 功能简介

数据转换提供输入、输出、转换等类型节点,可在抽数过程中对数据进行处理、清洗和加工,实现比较复杂的数据处理场景。

2 功能说明

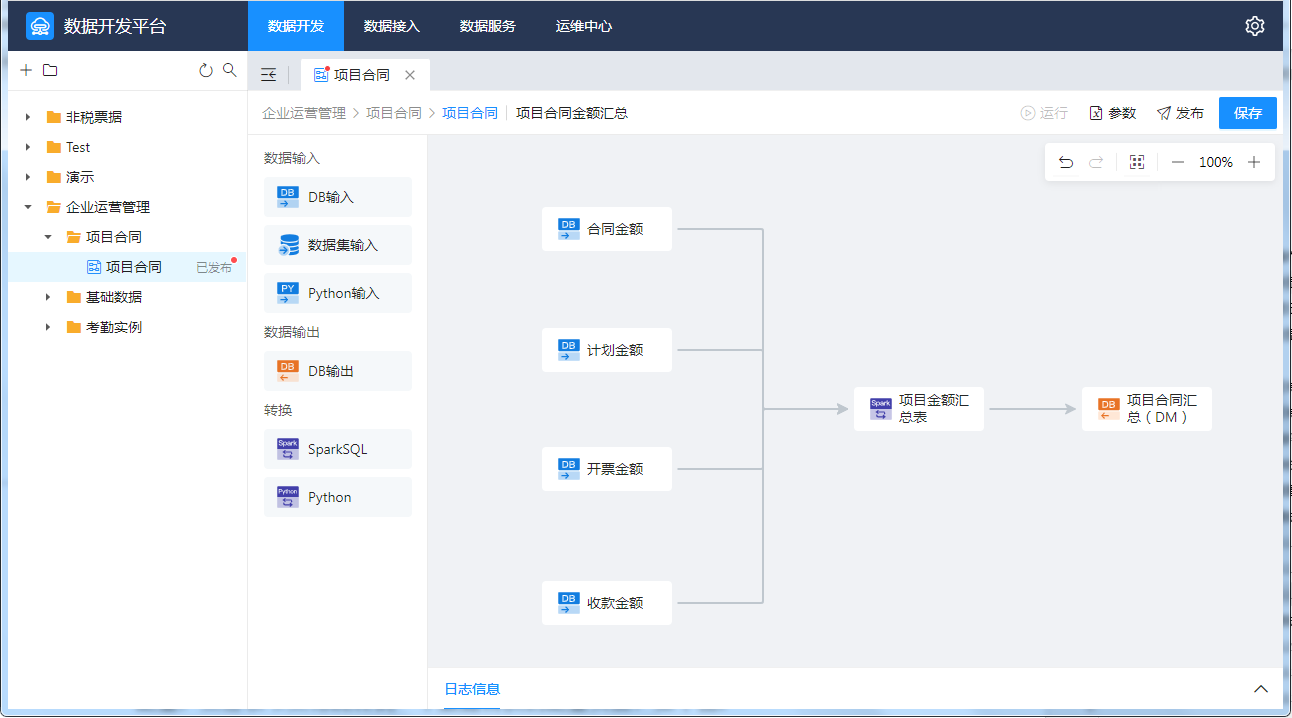

双击“数据转换”节点,进入设计界面,如下图:

支持的节点对应说明如下:

| 节点 | 说明 |

|---|---|

| DB输入 | 读取关系型数据库表中的数据 |

| 数据集输入 | 读取JDBC数据、存储过程、系统数据、MongoDB数据、Redis数据、接口数据等数据视图数据 |

| Python输入 | 用Python脚本获取的数据,作为后续环节的数据来源 |

| 文件输入 | 读取本地的 Excel 或 CSV 文件数据,作为后续环节的数据来源 |

| DB输出 | 将上游节点处理后的数据输出到目标数据库中 |

| 字段配置 | 对上游节点的输出字段进行重命名、数据类型转换、缺省值设置等操作 |

| 新增字段 | 可引用原有字段通过或计算获得一个新的字段 |

| 数据去重 | 对上游节点的重复数据记录进行聚合处理 |

| 数据过滤 | 通过设置过滤条件对数据进行过滤 |

| JSON解析 | 通过获取上游输出的 JSON 数据,将其自定义解析成需要的字段并输出给下游 |

| 列转行 | 可以将多个列的表头作为字段值,合并到一个新列中 |

| 行转列 | 可以将多行一列数据转为一行多列显示 |

| SparkSQL | 使用SparkSQL对抽取的数据进行查询和处理 |

| Python | 可调用Python脚本对抽取的数据进行复杂的数据处理 |

作者:fancy 创建时间:2024-06-13 10:45

最后编辑:fancy 更新时间:2026-01-21 14:48

最后编辑:fancy 更新时间:2026-01-21 14:48

扫码关注网盛数新公众号,获取更多帮助资料

扫码关注网盛数新公众号,获取更多帮助资料